人工智能的筹划和推理_圆柱体_图中

方案的另一方面办理了深度学习的黑盒寻衅。我们无法阐明模型如何始终如一地达到95%准确率这一事实并不虞味着无法阐明AI结果。模型性能可能无法实现临床采取,但模型透明度使我们更靠近终极目标,这是AI方案的一部分。与AI的所有领域一样,可阐明的AI[[2]]是一个研究领域,初创企业和研究职员致力于肃清对AI的预测。

除了方案之外,许多人工智能办理方案必须有推理元素。机器利用数据进行推理,这是推理的一种形式。人工智能领域的早期研究职员开拓了算法,并利用If/Then/Else规则来仿照人们用来办理问题和进行逻辑推理的大略分步推理。20世纪60年代早期的推理机和决策支持系统利用了这些技能。

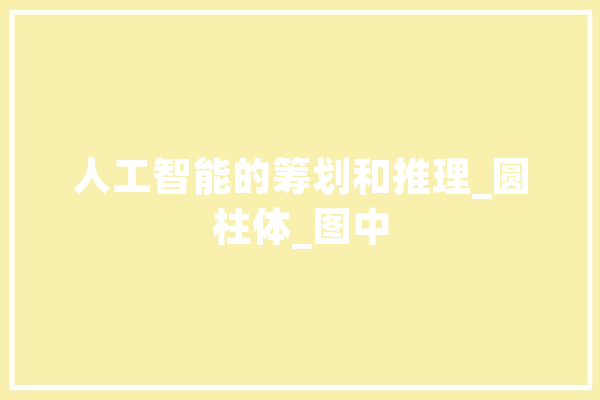

图 5不同形状的物体

机器学习比人类能更好地完成许多人类任务,但不能进行推理。图 5显示了两个不同尺寸的圆柱体和一个盒子的图像。

非关联型问题:

图中的白色圆柱体有多大?图中的盒子有多大?关联型问题:

图中是否有与白色圆柱体大小相同的东西?图中盒子顶部的玄色圆柱体右侧的圆柱体有多大?从关联问题的角度来看,上图的模型须要检讨不同形状、尺寸、颜色的物体,还能够回答和多个物体干系的问题。任何一个五岁的孩子都能回答图中所示的非关联型和关联型问题。但是,利用深度学习的打算机将无法理解不同事物之间的隐含关系,这一点人类做得相称好。

2017年6月,DeepMind揭橥了一篇论文,展示了一种新技能,关系网络[[3]],可以推理工具之间的关系。DeepMind推理结合利用了多种AI技能来得到关系问题的答案。在AI中开拓推理仍旧是一个不断发展的研究领域。须要推理的医疗保健办理方案将考虑新旧人工智能技能以及新兴研究。

[]仿真模型是一种现实的表示,紧张思想是肉眼看不到的东西变得可见。 ↑[]一个可以阐明的AI(Explainable AI,简称XAI)或透明的AI(Transparent AI),其行为可以被人类随意马虎理解。它与机器学习中“黑匣子”的观点形成光鲜比拟,这意味着繁芜算法运作的“可阐明性”,纵然他们的设计者也无法阐明人工智能为什么会做出详细决定。 ↑[]Google旗下的DeepMind,开拓出了全新的关系网络,以剖析比较某一特定场景中的每一组工具。 ↑本文系作者个人观点,不代表本站立场,转载请注明出处!