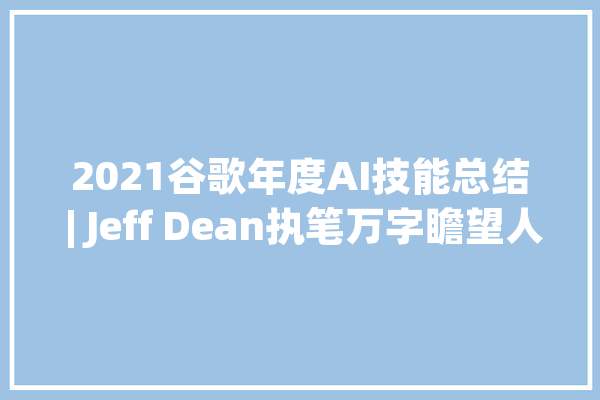

2021谷歌年度AI技能总结 | Jeff Dean执笔万字瞻望人工智能的5大年夜未来趋势_模子_数据

机器学习正在并且也将变得无处不在。

编译丨杏花、莓酊、王晔

编辑丨青暮

又是一年一度的谷歌年度盘点,Jeff Dean再次执笔,为我们回顾过去一年来谷歌在5大方向的研究进展以及未来趋势。

Jeff Dean表示,“在过去几十年里,我们见证了机器学习和打算机科学领域的许多重大变革。早期方法的失落效促进了当代方法的出身,并被证明非常有效。”

按照这种发展模式,他认为,我们将在未来几年内见证一些“令人愉快的进展”,这些进展终极将造福数十亿人的生活,产生比以往任何时候都更大的影响。

在这篇文章中,Jeff Dean重点先容了机器学习有望产生此等影响的五个方面。对付每个方面,他将谈论谷歌干系的研究(紧张是从2021年开始),以及在未来几年可能涌现的新方向和新进展。

这些方面分别涉及了算法、效率、个性化、环球化、任务:

算法上,基于Transformer的大规模预演习模型如今无论是在单模态数据的多任务通用性,以及多模态联合学习的能力上,都证明了自身的潜力;

效率上,从算力到模型演习、支配,机器学习流水线的效率正不断提高;在模型运行方面,编译器的改进和加速器软件的优化也供应了很大的助力;而架构方面的改进,自动化机器学习的持续发展、以及对模型稀疏性的利用,都让算法研究发展迅速;

个性化上,机器学习不仅运用变得更加广泛,而且越来越人性化,在功能上越来越自然,同时也更加看重隐私保护;

环球化上,机器学习的影响范围越来越广阔,涉及到愈发多样的环球性问题,比如科学研究、医疗、芯片设计、碳排放缓解、自然磨难预防等等;

末了是任务,只管饱受争议,但Jeff Dean表示,谷歌对付AI公正性非常重视,并从数据、算法、传播剖析、模型可阐明性、文化差异性研究以及大模型隐私保护上做了大量事情。

可以说,机器学习正在并且也将变得无处不在。

以下是关于五大趋势总结的编译先容:

1

趋势1:功能更强大、更通用的机器学习模型

如今,研究者正在演习比以往任何时候都更大型、功能更强大的机器学习模型。

例如,仅在最近几年,措辞领域的模型规模已经从在数百亿个数据标记上演习的数十亿个参数(例如,11B 参数的T5模型),发展到在数万亿个数据标记上演习的数百亿参数(例如,密集模型如 OpenAI 的 175B 参数 GPT-3 模型和 DeepMind 的 280B 参数 Gopher 模型,以及稀疏模型如 Google 的 600B 参数 GShard 模型和 1.2T 参数 GLaM 模型)。

数据集和模型规模的增强,使得各种措辞任务的准确性显著提高,正如标注自然措辞处理(NLP)基准任务的全面提升所表明的那样(例如对措辞模型和机器翻译模型的神经标度定律的研究所预测的)。

上述大部分高等模型都专注于书面措辞的单一但不可或缺的模态数据,并在措辞理解基准和开放式对话能力方面展现出最前辈的成果,乃至在一个领域中的多个任务中也具有如此表现。

此外,它们还表现出令人愉快的能力,可以在演习数据相对较少的情形下推广到新的措辞任务。某些情形下,新任务的演习示例很少乃至没有。例如,NLP中的改进长问答、零标签学习任务。谷歌还提出了LaMDA模型,该模型展示了一种繁芜的能力,可以进行开放式对话,在多轮对话中保持主要的高下文联系。

图注:“与 LaMDA 的对话,通过预设真实提示模拟威德尔海豹,“嗨,我是威德尔海豹。你有什么问题要问我吗?” 该模型在很大程度上保持了对话的角色特色。

Transformer 模型也对图像、***和语音模型产生了重大影响,正如视觉 Transformer 模型的标度定律所预测的那样,所有这些任务也都从规模扩展中受益匪浅。

用于图像识别和***分类的Transformer在许多基准上都取得了最前辈的成果,谷歌还证明,与单独利用***数据比较,在图像数据和***数据上的联合演习模型可以提高***任务的性能。

他们为图像和***Transformer开拓了稀疏的轴向把稳力机制,可以更有效地利用打算,为视觉Transformer模型找到更好的标记图像方法,并通过检讨视觉Transformer方法与卷积神经网络的操作办法比较,提高了对视觉Transformer方法的理解。将Transformer模型与卷积运算相结合,已在视觉和语音识别任务中显示出显著的优胜性。

天生模型的输出质量也在大幅提高,这在图像的天生模型中表现得最为明显。

例如,最近的模型已经证明,仅给定一个种别(例如,输入“爱尔兰塞特”或“有轨电车”)就可以创建逼真的图像,也可以通过修复低分辨率图像,以创建一个看起来自然的高分辨率匹配图像(例如,输入“打算机,增强!

”),乃至可以创建任意大小的自然场景。

另一个例子是,可以将图像转换为一系列离散标记,然后可以利用自回归天生模型以高保真度合成这些标记。

图注:级联扩散模型的示例,该模型从给定种别天生新图像,然后将其用作种子来创建高分辨率示例:第一个模型天生低分辨率图像,别的模型对终极高分辨率图像实行上采样。

SR3 超分辨率扩散模型将低分辨率图像作为输入,并从纯噪声构建相应的高分辨率图像。

***链接:https://iterative-refinement.github.io/assets/cascade_movie2_mp4.mp4

这些强大的功能背后,亦伴随着巨大的任务,因此谷歌表示会根据其 AI 原则仔细审查此类模型的潜在运用。

除了前辈的单模态模型外,谷歌也开始把稳大规模多模态模型的潜力。这些是迄今为止最前辈的模型,由于它们可以接管多种输入模态(例如,措辞、图像、语音、***),并可以天生多种输出模态,例如,基于描述性的句子或段落天生图像,或用人类措辞描述图像的视觉内容。

这是一个令人愉快的方向,由于和现实天下一样,在多模态数据中有些东西更随意马虎学习(例如,阅读并不雅观看演示比仅仅阅读更有用)。因此,将图像和文本配对可以帮助完成多措辞检索任务。并且,更好地理解如何将文本和图像输入配对,可以为图像描述任务带来更好的结果。

同样,对视觉和文本数据的联合演习也有助于提高视觉分类任务的准确性和鲁棒性,而对图像、***和音频任务的联合演习可以提高所有模态的泛化性能。

此外还有一些迹象表明,自然措辞可以用作图像处理的输入,见告机器人如何与天下交互并掌握其他软件系统,这预示着用户界面的开拓办法可能会发生变革。这些模型处理的模态将包括语音、声音、图像、***和措辞,乃至可能扩展到构造化数据、知识图谱和韶光序列数据。

图注:基于视觉的机器人操作系统示例,该系统能够泛化到新任务。左图:机器人正在实行一项基于“将葡萄放入陶瓷碗中”指令的任务,而模型并未接管该特界说务的演习。右图:类似左图,但任务描述为“将瓶子放入托盘”。

这些模型常日利用自监督学习方法进行演习,个中模型从未经标记的“原始”数据的不雅观察中学习,例如 GPT-3 和 GLaM 中利用的措辞模型、自监督语音模型 BigSSL 、视觉比拟学习模型 SimCLR 和多模态比拟模型 VATT。自监督学习让大型语音识别模型得以达到之前的语音搜索自动语音识别 (ASR) 基准的准确度,同时仅利用 3% 的带注释演习数据。

这些趋势令人愉快,由于它们可以大大减少为特界说务启用机器学习所需的事情量,并且由于使得在更具代表性的数据上演习模型变得更随意马虎,这些数据更好地反响了不同的亚群、地区、措辞,或其他主要的表示维度。

所有这些趋势都指向演习功能强大的通用模型的方向,这些模型可以处理多种数据模式,并办理成千上万个任务。通过构建稀疏性模型,使得模型中唯一被给界说务激活的部分,仅有那些为其优化过的部分,从而这些多模态模型可以变得高效。

Jeff Dean表示,在接下来的几年里,谷歌将基于Pathways架构追求这一愿景。

Pathways:谷歌正在努力的统一模型,可以泛化至数百万个任务。

2

趋势2:机器学习效率的持续提升

由于打算机硬件设计以及机器学习算法和元学习研究的进步,机器学习的效率得到持续提升,推动着机器学习模型的功能变得更加强大。

ML 流水线涉及许多方面,从演习和实行模型的硬件,到 ML 架构的各个组件,都可以进行效率优化,同时保持或提高整体性能。

与前几年比较,这些线程中的每一个都可以以显著的乘法因子提高效率,并且综合起来可以将打算本钱(包括二氧化碳当量排放量)降落几个数量级。

更高的效率匆匆成了许多关键的进步,这些进步将连续显著提高机器学习的效率,使更大、更高质量的机器学习模型能够以高效的办法开拓,并进一步使访问公正化。

ML 加速器性能的持续改进

每一代 ML 加速器都在前几代的根本上进行了改进,使每个芯片的性能更快,并且常日可以扩大全体系统的规模。

去年,谷歌发布了其TPUv4 系统,这是谷歌的第四代张量处理单元,它在 MLPerf 基准测试中比 TPUv3 提升了 2.7 倍。TPUv4 芯片的峰值性能是 TPUv3 芯片的约 2 倍,每个 TPUv4 pod 的规模为 4096 个芯片(是 TPUv3 pod 的 4 倍),每个 pod 的性能约为 1.1 exaflops(而每个 TPUv3 pod约为 100 petaflops)。拥有大量芯片并通过高速网络连接在一起的 Pod 可以提高大型模型的效率。

此外,移动设备上的机器学习能力也在显著提高。Pixel 6 手机采取全新的 Google Tensor 处理器,该处理器集成了强大的 ML 加速器,以更好地支持主要的设备功能。

左:TPUv4 主板;中:TPUv4 pod的一部分;右图:在 Pixel 6 手机中的 Google Tensor 芯片。

Jeff Dean表示,谷歌利用 ML 来加速各种打算机芯片的设计也带来了好处,特殊是在生产更好的 ML 加速器方面。

ML 编译和 ML 事情负载优化的持续改进

纵然硬件不变,编译器的改进和机器学习加速器系统软件的其他优化也可以显著提高效率。

例如,“A Flexible Approach to Autotuning Multi-pass Machine Learning Compilers”展示了如何利用机器学习来实行编译设置的自动调度,用于同一底层硬件上的一套 ML 程序,以得到 5-15% 的全面性能提升(有时乃至高达2.4 倍改进)。

此外,GSPMD 描述了一种基于 XLA 编译器的自动并行化系统,该系统能够将大多数深度学习网络架构扩展到加速器的内存容量之外,并已运用于许多大型模型,例如 GShard-M4、LaMDA、BigSSL、ViT、MetNet -2 和 GLaM,在多个领域产生了最前辈的成果。

图注:通过在 150 个 ML 模型上利用基于 ML 的编译器自动调度实现端到端模型加速。图中包括实现 5% 或更多改进的模型。条形颜色代表优化不同模型组件的相对改进。

人类创造的更高效模型架构

模型架构的持续改进大大减少了为许多问题实现给定精度水平所需的打算量。

例如,谷歌在 2017 年开拓的 Transformer 架构能够提高在多个 NLP 基准上确当前最佳水平,同时利用比其他各种常用方法少 10 到 100 倍的打算来实现这些结果,例如 LSTM 和其他循环架构。

同样,只管利用的打算量比卷积神经网络少 4 到 10 倍,但视觉 Transformer 能够在许多不同的图像分类任务上显示出改进的最前辈结果。

机器驱动的更高效模型架构的创造

神经架构搜索(NAS)可以自动创造对给定问题域更有效的新 ML 架构。NAS 的一个紧张优点是它可以大大减少算法开拓所需的事情量,由于 NAS 只须要对每个搜索空间和问题域组合进行单次考验。

此外,虽然实行 NAS 的初始事情在打算上可能很昂贵,但由此产生的模型可以大大减少下贱研究和生产设置中的打算,从而大大降落总体资源需求。

例如,创造 Evolved Transformer 的单次搜索仅产生了 3.2 吨二氧化碳当量(远低于其他地方报告的 284 吨二氧化碳当量),但产生了一个比普通的 Transformer 模型效率高 15-20%的模型。

最近,谷歌利用 NAS 创造了一种更高效的架构,称为 Primer(也已开源),与普通的 Transformer 模型比较,它可以将演习本钱降落 4 倍。通过这种办法,NAS 搜索的创造本钱常日可以从利用创造的更有效的模型架构中收回,纵然它们仅运用于少数下贱任务(NAS 结果可被重复利用数千次)。

图注:NAS 创造的 Primer 架构的效率是普通 Transformer 模型的 4 倍。这张图片赤色部分显示了 Primer 得到大部分改进的两个紧张修正:添加到把稳力多头投影的深度卷积和平方 ReLU 激活(蓝色表示原始 Transformer 的部分)。

NAS还被用于在视觉领域创造更有效的模型。EfficientNetV2 模型架构是神经架构搜索的结果,它联合优化了模型精度、模型大小和演习速率。在 ImageNet 基准测试中,EfficientNetV2 将演习速率提高了 5 到 11 倍,同时与以前最前辈的模型比较,模型参数大大减少。

CoAtNet 模型架构是通过架构搜索创造的,结合了视觉 Transformer 和卷积网络来创建一个稠浊模型架构,其演习速率比视觉 Transformer 快 4 倍,并实现了新的 ImageNet 最前辈结果。

图注:EfficientNetV2 的演习效率比之前的 ImageNet 分类模型要好得多。

广泛利用搜索来帮助改进 ML 模型架构和算法,包括利用强化学习和进化技能,引发了其他研究职员将这种方法运用于不同领域。

除了模型架构之外,自动搜索还可用于探求新的、更有效的强化学习算法,建立在早期的 AutoML-Zero 事情的根本上。

稀疏性的利用

稀疏性模型具有非常大的容量,但对付给定的数据(示例或 token ),只有模型的某些部分被激活,这是另一个可以大大提高效率的主要算法进步。

2017 年,谷歌引入了稀疏门控稠浊专家层,该层在各种翻译基准上展示了更好的结果,同时利用的打算量比以前最前辈的密集 LSTM 模型少 10 倍。

最近,Switch Transformers 将稠浊专家风格的架构与 Transformer 模型架构相结合,与密集的 T5-Base Transformer 模型比较,演习韶光和效率提高了 7 倍。

GLaM 模型表明,Transformer 和稠浊专家风格的层可以结合起来天生一个模型,该模型在 29 个基准测试中均匀超过 GPT-3 模型的准确性,而演习的能耗减少了 3 倍,推理的打算量减少了 2 倍。稀疏性的观点也可以用于降落Transformer 架构中把稳力机制的本钱。

图注:BigBird 稀疏把稳力模型由关注输入序列所有部分的全局标记、局部标记和一组随机标记组成。从理论上讲,这可以阐明为在 Watts-Strogatz 图上添加一些全局标记。

在模型中利用稀疏性,显然是一种在打算效率方面具有非常高潜力的方法。Jeff Dean 表示,谷歌只是在这个方向上触及了皮毛。

与利用 P100 GPU 演习的基线 Transformer 模型比较,这些提高效率的方法中的每一种都可以组合在一起,可将高效数据中央演习的等效精度措辞模型的能源效率提高约 100 倍,产生的二氧化碳排放量减少约 650 倍。

Jeff Dean表示,其团队很快就会揭橥更为详细的博客文章剖析 NLP 模型的碳排放趋势。

3

趋势3:机器学习正推动个人和社区的发展

ML 和诸如手机上的Tensor 处理器等硅基硬件的创新,使得移动设备可以更持续有效地感知周围环境,而这将为用户带来一系列新的体验。

他认为这种进步不仅提高了其可及性、易用性,而且提升了打算的能力,这对改进移动拍照、实时翻译等功能也至关主要。值得把稳的是,这种最新的技能在为用户供应更加个性化体验的同时,还加强了隐私保障方法。

目前,利用手机摄像来记录日常生活或进行艺术表达的热度空前。Jeff Dean 认为,ML 在打算拍照中的奥妙利用,可以不断促进手机相机功能的提升,使其操作起来更加随意马虎,也可以提高拍摄性能,产生更高质量的图像。

比如,经由改进的HDR+,在非常低的光芒下就可以很好地处理人像,使相机更具原谅性,并且适用于所有肤色,可以拍摄出能够达到拍照师预想视觉效果并且更符合主题的照片。

不仅如此,基于 ML 的 Google Photos 工具,像电影照片、降噪、模糊以及魔术橡皮擦等,可以进一步完善照片。

图注:HDR+ 从持续串全分辨率原始图像开始,每个图像都有相同的曝光不敷(左)。领悟后的图像减少了噪点并增加了动态范围,从而得到了更高质量的终极图像(右)。

除了利用手机进行创作外,Jeff Dean 还列举了人们依赖手机进行跨措辞和跨模式的实时沟通的例子,比如在运用程序中利用实时翻译,在通话互换中利用实时字幕等。

得益于自监督学习和噪声学生演习(Noisy Student Training)等技能的进步,语音识别的准确率在重音、喧华环境或语音重叠和多措辞环境下,都有明显提高。基于从文本到语音合成方面的进展,越来越多的平台推出了朗读技能,许可儿们用听的办法获取网页或文章内容,使信息更随意马虎超过模态和措辞的障碍。

稳定、实时天生的翻译以及高质量、稳定、有保障的直接语音翻译,为利用不同措辞互换的人们供应了更好的用户体验,机器翻译中的实时语音翻译功能也已得到极大改进。

将ML与传统的编解码方法相结合的新事情,可以匆匆使更高保真度的语音、音乐或其它声音以更低的比特率进行互换。另一方面,Jeff Dean 还表示像自动呼叫或者与 ML 智能体进行的一些日常互动性的功能变得越来越自然。

纵然是用户可能会常常进行的,像智能文本选择等这样的大略任务也得到了改进,可以实现自动选择电话号码或地址等,能够方便复制粘贴,或者在手机上输入时的语法纠正。

此外,“屏幕把稳(Screen Attention )”可防止手机屏幕在被注目时变暗,并且注目识别(Gaze Recognition)的改进为可访问性和改进康健状况开辟了新的用例。ML 也正在启用新的方法来保障人们和社区的安全。例如,\"大众可疑信息警报 ( Suspicious Message Alerts )\"大众 对可能存在的网络钓鱼攻击发出警告、\公众安全路线(Safer Routing ) \"大众 可以检测到急刹车事宜以及供应建议替代路线。

图注:最近的事情证明了注目识别可作为精神疲倦的主要生物标志物。

然而,这些新功能的开拓离不开数据支撑,Jeff Dean 表示鉴于个中潜在的敏感性问题,将其设置为在默认状态下私有是非常有必要的。

个中的很多功能是在安卓私有的打算核心内运行,供应了一个与操作系统其它部分隔离的开源安全环境。安卓系统可以确保在私有打算核心中处理的数据不会在用户不知情的情形下分享给任何运用程序。安卓系统还防止私有打算核心内的任何功能直接访问网络。

相反,这些功能通过一小套开源 API 与私有打算做事进行通信,私有打算做事剥离了识别信息,并利用了包括联邦学习、联邦剖析和私人信息检索在内的隐私技能,确保在学习的同时保护隐私。

图注:联邦重修是一种新颖的部分局部联邦学习技能,个中模型被划分为全局和局部参数。对付每一轮联邦重修演习:(1) 做事器将当前全局参数 g 发送给每个用户 i;(2) 每个用户 i 冻结 g 并重修他们的局部参数 l_i;(3) 每个用户i冻结 l_i 并更新 g 产生 g_i ;(4) 对用户的 g_i 取均匀值,天生下一轮的全局参数。

在 Jeff Dean 看来,这些技能对付发展下一代打算和交互模式至关主要。个人或公共设备可以在不陵犯隐私的情形下,从集体模型中学习,并推动模型演习的进步。

用联合无监督的方法来学习上述的通用模型,并针对特定的任务或环境进行微调,可以产生越来越多的智能系统,这些系统更像是一个社会实体而不是机器,与之互动要更为直不雅观。只有从边缘到数据中央,深入改变技能堆栈(technology stacks),使其适当支持神经打算,才有可能广泛而公正地利用这些智能接口。

4

趋势4:机器学习对科学、康健和可持续发展的影响越来越大

近年来,谷歌看到 ML 在根本科学中的影响越来越大,从物理学到生物学,在许多干系领域(例如可再生能源和医学)中都具有令人愉快的实际运用。

打算机视觉模型已被支配用来办理个人和环球范围内的问题,它们可以帮忙年夜夫进行日常事情,扩大人们对神全心理学的理解,还可以供应更好的景象预报结果和简化救灾事情。

通过创造减少碳排放和提高替代能源输出的方法,其他类型的 ML 模型被证明在应对景象变革方面至关主要。

随着 ML 变得更加健壮、完善和得到更广泛的访问,它在广泛的现实天下领域中具有高影响力的运用的潜力连续扩大,有助于办理研究职员面临的一些最具寻衅性的问题。

打算机视觉的大规模运用以得到新的洞察力

过去十年,打算机视觉的进步使打算机能够用于不同科学领域的各种任务。比如,在神经科学中,自动重修技能可以从脑组织薄片的高分辨率电子显微镜图像中规复脑组织的神经结缔构造。

前几年,谷歌为果蝇、小鼠和鸣禽的大脑创建了此类资源。但在去年,他们与哈佛大学的 Lichtman 实验室互助,剖析了以相同粒度成像和重修的多种物种的大脑组织样本,并首次对人类皮层中的突触连接进行了大规模研究,该研究超过了皮层所有层的多种细胞类型。

这项事情的目标是得到一种新的资源来帮助神经科学家研究人类大脑的繁芜性。例如,下图显示了成人大脑中约 860 亿个神经元中的 6 个神经元。

图注:来自人类皮层重修的单个人类枝形吊灯神经元,以及与该细胞连接的一些锥体神经元。

此外,打算机视觉技能还供应了强大的工具来应对更大乃至环球范围内的寻衅。

例如,基于深度学习的景象预报方法,该方法利用卫星和雷达图像作为输入,结合其他大气数据,在长达 12 小时的预测韶光内,产生比传统的基于物理的模型更准确的景象和降水预报。与传统方法比较,它们还可以更快地天生新的预测,这在极度景象中非常主要。

图注:2020 年 3 月 30 日,不同模型预测科罗拉多州丹佛市 0.2 毫米/小时降水量的比较。左图:真实数据,来源(MRMS)。中间:MetNet-2 预测的概率图。右图:基于物理的 HREF 模型预测的概率图。MetNet-2 能够在预测中比 HREF 更早地预测风暴的开始以及风暴的起始位置,而 HREF 错过了起始位置,但很好地捕捉到了成长阶段。

准确记录建筑足迹对付人口估计和城市方案等一系列运用至关主要。在世界许多地方,包括非洲大部分地区,这些信息以前都是不可用的。

但新事情表明,将打算机视觉技能运用于卫星图像可以帮助识别大陆尺度的建筑边界。这种方法的干系结果已在 Open Buildings 数据集中发布,这是一个新的开放访问数据资源,个中包含 5.16 亿座建筑物的位置和足迹,覆盖非洲大陆的大部分地区。

Jeff Dean 团队还在与天下粮食操持署的互助中利用这个数据集,通过运用机器学习在自然磨难后供应快速的危害评估。

在卫星图像等分割建筑物的示例。左:源图像;中:语义分割,每个像素都分配了一个置信度分数,表明它是建筑物还是非建筑物;右图:实例分割,通过对连接组件进行阈值化和分组得到。

这些案例反响出的一个共同主题是,ML 模型能够基于对可用视觉数据的剖析,高效、准确地实行专门的任务,支持高度干系的下贱任务。

自动化设计空间探索

另一种在多个领域取得成果的方法是,许可 ML 算法以自动化办法探索和评估问题的设计空间以探求可能的办理方案。

比如在一个运用程序中,基于 Transformer 的变分自动编码器学习创建都雅且有用的文档布局,并且可以扩展相同的方法来探索可能的家具布局。

另一种 ML 驱动的方法自动探索游戏规则的巨大设计空间,以提高游戏的可玩性和其他属性,使人类游戏设计师能够更快地创建令人愉快的游戏。

图注:变分Transformer网络 (VTN) 模型的可视化,它能够提取布局元素(段落、表格、图像等)之间的故意义的关系,以天生逼真的合成文档(例如,具有更好的对齐和边距)。

其他 ML 算法已被用于评估 ML 加速器芯片本身的打算机架构决策的设计空间。

谷歌还表明,ML 可用于为 ASIC 设计快速创建芯片布局,这些布局优于人类专家天生的布局,并且可以在几小时而不是几周内天生。这降落了芯片的固定工程本钱,并降落了为不同运用快速创建专用硬件的障碍。他们在即将推出的 TPU-v5 芯片的设计中成功地利用了这种方法。

这种探索性 ML 方法也已运用于材料创造。在 Google Research 和加州理工学院的互助中,几个 ML 模型与改进的喷墨打印机和定制的显微镜相结合,能够快速搜索数十万种可能的材料,创造了 51 种以前未表征的三金属氧化物质料,在电池技能和水电解等领域具有运用前景。

这些自动化的设计空间探索方法可以帮助加速许多科学领域,特殊是当天生实验和评估结果的全体实验循环都可以以自动化或大部分自动化的办法完成时。Jeff Dean 表示,希望看到这种方法在未来几年在更多领域中发挥良好的效果。

在康健领域的运用

除了推进根本科学,机器学习还可以更广泛地推动医学和人类康健的进步。

利用打算机科学在康健方面并不是什么新鲜事——事实上,谷歌早期就开拓软件来帮助剖析盛行病学数据。但是机器学习打开了新的大门,带来了新的机会,也带来了新的寻衅。

以基因组学领域为例。自基因组学问世以来,打算一贯很主要,但 ML 增加了新功能并推翻了旧范式。当谷歌研究职员开始在这一领域事情时,许多专家认为利用深度学习帮助从测序仪输出推断遗传变异的想法是牵强附会的。

本日,这种机器学习方法被认为是最前辈的。但未来对付 ML 来说将扮演更主要的角色——基因组学公司正在开拓更准确、更快的新测序仪器,但也带来了新的推理寻衅。

谷歌发布的开源软件 DeepConsensus 以及与 UCSC 互助的 PEPPER-DeepVariant 支持这些具有尖端信息学的新仪器。

图注:DeepConsensus 的 Transformer 架构示意图,可纠正测序缺点以提高产量和准确性。

除了处理测序仪数据之外,还有其他机会利用 ML 来加速研究职员将基因组信息用于个性化康健。广泛表型和测序个体的大型生物库可以彻底改变人们理解和管理疾病遗传易感性的办法。

Jeff Dean 等人基于 ML 的表型剖析方法提高了将大型成像和文本数据集转换为可用于遗传关联研究的表型的可扩展性,他们的 DeepNull 方法更好地利用大型表型数据进行遗传创造,并且已经开源。

图注:天生解剖和疾病特色的大规模量化以与生物库中的基因组数据相结合的过程。

正如 ML 帮助研究职员看到基因组数据的隐蔽特色一样,它也可以帮助创造新信息并从其他康健数据类型中网络新见地。疾病诊断常日是关于识别模式、量化干系性或识别更大类别的新实例——这些都是 ML 善于的任务。

谷歌研究职员已经利用 ML 办理了广泛此类问题,但大概这些问题都没有比 ML 在医学成像中的运用更进一步。

事实上,谷歌 2016 年的论文描述了深度学习在糖尿病性视网膜病变筛查中的运用,被美国医学会杂志 (JAMA) 的编辑选为十年来最具影响力的 10 篇论文之一——不仅仅是机器学习和康健方面最有影响力的论文,乃至是全体十年中最具影响力的 JAMA 论文。

Jeff Dean 表示,其团队成员希望看到这种相同模式的赞助 ML 系统被支配用于改进乳腺癌筛查、检测肺癌、加速癌症放射治疗、标记非常 X 射线和分期前列腺癌活检。

ML 赞助结肠镜检讨程序是更高阶的有趣例子。结肠镜检讨不仅用于诊断结肠癌——在手术过程中切除息肉是阻挡疾病进展和预防严重疾病的主要部分。在这个领域,研究职员已经证明 ML 可以帮助检测难以捉摸的息肉,并且可以增加质量担保的新维度,例如通过运用同步定位和映射技能进行覆盖映射。

通过与耶路撒冷的 Shaare Zedek 医疗中央互助,谷歌展示了这些系统可以实时事情,在每次手术中均匀检测到一个原来会被漏掉的息肉,每次手术的误报少于四个。

图注:胸部 X 光片 (CXR) 的真假阳性样本,以及 (A) 一样平常非常、(B) 结核病和 (C) COVID-19 的真假阴性结果。在每个 CXR 上,赤色轮廓表示模型重点识别非常的区域(即类激活图),黄色轮廓表示放射科年夜夫识别的感兴趣区域。

另一个医疗保健操持 Care Studio 利用最前辈的 ML 和前辈的 NLP 技能来剖析构造化数据和医疗记录,在精确的韶光向临床年夜夫供应最干系的信息——终极帮助他们供应更主动和准确的照顾护士。

只管 ML 可能对扩大临床环境的可及性和提高准确性很主要,但一个同样主要的新趋势正在涌现:ML 运用于帮助人们提高日常康健和福祉。

我们的日常设备具有强大的传感器,可以帮助使康健指标和信息民主化,以便人们可以就自己的康健做出更明智的决定。

智好手机摄像头已经可以评估心率和呼吸频率以帮助用户,而无需额外硬件的发布,以及支持非打仗式就寝感应,并让用户更好地理解他们的夜间康健状况的设备。

一方面,个人可以在自己的 ASR 系统中显著提高无序语音的语音识别质量,另一方面,还可以利用 ML 帮助重修有语音障碍的人的声音。支持机器学习的智好手机乃至可以帮助人们更好地研究新涌现的皮肤状况或帮助视力有限的人慢跑。

图注:用于非打仗式就寝感应的自定义 ML 模型有效地处理连续的 3D 雷达张量流(总结一系列间隔、频率和韶光的活动),以自动打算用户复苏或睡着的可能性的概率。

机器学习在景象危急上的运用

另一个最主要的领域是景象变革,这对人类来说是一个极其紧迫的威胁。

因此,人们须要共同努力,旋转有害排放物的增长曲线,以确保安全和繁荣的未来。关于不同选择对景象带来的影响的信息可以帮助人类以多种不同办法应对这一寻衅。

为此,谷歌最近在 Google 舆图中推出了环保路线推举运用,他们估计这将每年减少约 100 万吨二氧化碳排放(相称于从道路上减少 200,000 多辆汽车)。

此外,让舆图产品更智能地理解电动汽车有助于缓解里程焦虑,鼓励人们改用无排放汽车。谷歌还与天下各地的多个城市互助,利用汇总的历史交通数据来帮助改进交通信号灯韶光设置,在以色列和巴西进行的一项早期试点研究表明,燃料花费和耽误韶光可以减少10-20%。

图注:借助环保路线运用,Google 舆图可以显示快和省油的路线。

在更长的韶光范围内,聚变有望成为改变游戏规则的可再生能源。在与 TAE Technologies 的长期互助中,谷歌利用 ML 通过建议设置 1000 多个干系掌握参数来帮助坚持其聚变反应堆中的稳定等离子体。

通过他们的互助,TAE 实现了诺曼反应堆的紧张目标,这使研究职员离盈亏平衡聚变的目标更近了一步。该机器在 30 毫秒内保持 3000 万开尔文的稳定等离子体,这是其系统可用功率的范围。

谷歌也在关注自然磨难预防。去年,他们推出了由卫星数据供应支持的野火边界图,以帮助人们直接通过设备轻松理解失火的大致规模和位置。

在此根本上,研究职员现在将谷歌的所有野火信息整合在一起,并在环球范围内推出谷歌舆图上的新图层。他们一贯在运用图形优化算法来帮助优化失火疏散路线。

2021 年,谷歌首次在实际的大水预警系统中支配了基于 LSTM 的预测模型和新的模型( Manifold inundation model)。

图注:Google 舆图中的野火层可在紧急情形下为人们供应主要的最新信息。

ML 模型演习的碳排放是 ML 社区关注的问题,谷歌已经证明了关于模型架构、数据中央和 ML 加速器类型的选择可以将演习的碳足迹减少约 100-1000 倍。

5

趋势5:对机器学习更深入的理解

随着机器学习被更广泛地接管和运用,连续开拓新技能可以推进机器学习更好地造福于社会。

基于在线产品中的用户活动的推举系统便是个中一个。常日推举系统是由多个不同组件构成的,想要理解它们的公正属性,须要理解各个组件以及它们组合时的运行办法。

谷歌最新的研究提高了单个组件和整体推举系统的公正性,帮助用户更好地理解这些“关联性”。而且,在从匿名用户活动中学习时,推举系统以“中立”的办法学习至是十分必要的。从先前用户的数据中直接学习到的“履历”,可能带有显而易见的“偏见”。如果不纠正,那新用户可能会频繁收到不符合心意的产品推举。

与推举系统类似,高下文环境在机器翻译中至关主要。大多数机器翻译系统都是孤立地翻译单个句子,没参考额外的高下文内容,无意间添加了性别、年事等“歧视”属性。谷歌去年公布了一个专门针对翻译中性别偏见的数据集,用来研究基于维基百科传记的翻译偏见。

支配机器学习模型中另一个常见问题是分布偏移(distributional shift):如果演习模型数据的统计分布与输入模型数据的统计分布不同,可能造成模型产生的结果不可预测。

谷歌利用 Deep Bootstrap 框架比拟有限演习数据的现实天下与无限数据的“大同天下”。从而更好地理解模型的行为(真实中与空想中的天下),研究职员可以开拓泛化性更强的模型,对固定演习数据集减少“偏见”。

虽然机器学习算法和模型开拓一贯备受关注,但数据网络和数据集管理类的事情相对较少。毋庸置疑,它们是不可忽略的领域,由于演习机器模型所依据的数据可能是下贱运用程序中公正性问题的潜在来源。剖析机器学习中此类数据级联,将有助于识别项目周期中对结果产生重大影响的许多成分。

图注:不同颜色的箭头表示各种类型的数据级联,每个级联常日起源于上游,在ML开拓过程中复合,并不才游呈现。

更好地理解数据是机器学习研究的一个核心环节。谷歌开拓了一类方法能够深入理解特定演习示例对机器学习模型的影响,由于缺点标记的数据或其他类似问题对整体模型都有巨大负面影响。谷歌还构建了Know Your Data 工具,用以帮助研究职员和从业者节制数据集属性,例如:如何利用 Know Your Data 工具来探索性别、年事偏见等问题。

图注:Know Your Data 的数据显示了描述吸引力的词与性别词之间的关系

理解基准数据集利用的动态也十分必要,由于它们在机器学习领域的中发挥着核心浸染。只管对单个数据集的研究变得更为遍及,但全体领域的数据集利用动态仍有神秘领域待探索。最近谷歌揭橥了第一个关于数据集创建、采取和重用动态的大规模实证剖析。

创建更具原谅性和更少偏见的公共数据集是可以改进机器学习领域的主要方法。2016 年,谷歌发布了 Open Images 数据集,该数据集包含约 900 万张图像,标注了涵盖数千个工具类别的图像标签和 600 个类别的边界框注释。

去年,Jeff Dean团队在 Open Images Extended 凑集中引入了更具原谅性的人物注释 (MIAP) 数据集。它有更完全的人类边界框注释,像感知性别表示和感知年事范围等都标有更为公正的属性。同时,研究职员还构建了数据集搜索来帮助用户创造新的数据集。

处理各种形式的在线滥用行为,例如有害辞吐、仇恨辞吐和缺点信息等,能够有效大规模检测这类滥用形式,对确保平台安全、避免通过以无人监督的办法从在线话语中学习措辞的此类负面特色的风险至关主要。

谷歌通过 Perspective API 工具进行了事情,但大规模检测有害性所涉及的细微差别仍旧是高难度寻衅。Jeff Dean等引入了全面分类法来推理在线仇恨和骚扰的辞吐变革局势。

他们同样研究了如何检测在网络中常被忽略的暗藏有害形式,例如微歧视(microaggression)。研究了如何用传统方法处理数据注释中的歧视,这些主不雅观观点会边缘化少数人的不雅观点,并提出了一种新的基于多任务框架的分类建模方法。

其他的潜在问题是,机器学习措辞理解和天生模型有时也会产生短缺证据支持的结果。为了在问答、总结和对话中办理这个问题,谷歌开拓了一个新框架衡量结果是否可以归因于特定来源,并随后发布了注释指南,证明能够可靠地用于评估候选模型。

模型交互式剖析和调试仍旧是机器学习的关键。谷歌更新了措辞可阐明性工具,用新功能和技能推进这项事情,包括对图像和表格数据的支持,以及内置支持通过观点激活向量测试技能进行公正性剖析等。

机器学习系统的可阐明性和对模型决策过程的事后可重修性也是谷歌负任务的AI 愿景的关键部分。通过与 DeepMind 互助,研究职员在理解人类国际象棋观点在自对弈演习的 AlphaZero 国际象棋系统中的获取上取得了进展。

图注:探索 AlphaZero 学习到的国际象棋观点。

谷歌也在将人工智能的视野拓宽到西方背景之外。他们最近的研究考验了基于西方机构和根本举动步伐的传统算法公正框架的假设为何在非西方背景下不适应。

他们正在多个国家积极开展调查研究,以理解人们对人工智能的意见和偏好。西方对算法公正性研究的框架每每只关注少数几个属性,因此关于非西方背景的偏见在很大程度上被忽略,在履历上研究不敷。

为理解决这一问题,谷歌与密歇根大学互助,开拓了一种弱监督方法,在 NLP 模型中稳健地检测更广泛的地理文化背景中的词汇偏差,这些模型反响了人类在这些区域中对攻击性和非攻击性措辞的判断。

此外,他们还探索了 ML在南半球主导的环境中的运用,包括为以庄家为中央的机器学习研究提出建议。

基于社区的研究方法,也为谷歌设计数字福祉和解决机器学习系统中的种族平等问题供应了依据,包括提高对非裔美国人利用 ASR 系统体验的理解。

随着ML模型在许多领域的运用,私有信息的保护一贯是研究的重点。沿着这些思路,谷歌最新研究办理了大型模型中的隐私问题,既强调了从大型模型中提取演习数据,也指出了在大型模型中实现隐私的方法,例如差分私有BERT。

除了上面提到的联邦学习和剖析方面的事情之外,利用实用的机器学习技能从而增强研究职员的工具箱,确保差分隐私,比如私有聚类、私有个性化、私有矩阵完成、私有加权采样、私有分位数、半空间的私有鲁棒学习,以及普遍样本高效的私有 PAC 学习,还有扩展可针对不同运用程序和模型定制的隐私观点集,像标签隐私和用户与项目级别的隐私。

图注:差分私有聚类算法的可视化图示。

6

结语

研究常日是对现实天下产生影响的长期进程。几年前发生的早期研究事情现在对谷歌乃至全天下都产生了巨大的影响。

对ML 硬件加速器以及软件框架的投资已取得成果。ML 模型在许多不同产品和功能中越来越普遍,由于它们的强大功能和易于表达的特点简化了 ML 模型在性能关键环境中的实验和生产。

对创建 Seq2Seq、Inception、EfficientNet 和 Transformer 的模型架构的研究或批归一化和蒸馏等算法研究正在推动措辞理解、视觉、语音等领域的进步。

更好的措辞和视觉理解以及语音识别等基本功能或许将具有变革性,因此,这些类型的模型被广泛支配用于办理许多产品中的各种问题,包括搜索、助理、广告、云、邮箱、舆图、***、和翻译等等。

这些是机器学习和打算机科学真正激动民气的时候。打算机通过措辞、视觉和声音理解和与周围天下互动的能力不断提高,这为打算机如何帮助人们完成任意的任务开辟了全新的领域。这篇文章概述的五个趋势中谈到的示例将是这个长期进程中的路标!

原文链接:https://ai.googleblog.com/2022/01/google-research-themes-from-2021-and.html

干系阅读

谷歌等戳穿「AI任务疑难」:存在局限的ImageNet等基准,就像无法代表「全体天下」的博物馆

2022-01-03

与Jeff Dean聊ML for EDA,最佳论文花落伯克利:EDA顶级会议DAC 2021 精彩回顾

2021-12-19

谷歌科学家:目标优化不好使?本日聊聊泛化这件事儿

2021-10-29

雷峰网

本文系作者个人观点,不代表本站立场,转载请注明出处!